NISQ-Computer: Quantenverschränkung ist manchmal ein zweischneidiges Schwert

Theoretiker am MPQ haben in einer neuen Arbeit untersucht, welche Auswirkungen die Ausbreitung von Fehlern auf die Qualität der Berechnungen klassischer Optimierungsprobleme auf NISQ-Computern haben.

Das Interesse an Quantencomputern ist groß, denn es besteht die Hoffnung, dass sie bestimmte Rechenaufgaben wesentlich schneller erledigen können als klassische Computer. Der Bau eines Quantencomputers gestaltet sich jedoch als außerordentlich schwierig und die Wissenschaft ist noch Jahre davon entfernt, Quantenrechner zu bauen, die vollkommen fehlerfrei operieren können – was langfristig das Ziel ist. Nicht außer Acht zu lassen sind jedoch die jüngsten experimentellen Fortschritte bei der Quantenhardware, die den Zugang zu kleinen bis mittelgroßen, fehlerhaften (engl. noisy für zu Deutsch rauschend) Quantencomputern ermöglichen. Sie werden in der Fachsprache als NISQ-Computer bezeichnet, kurz für Noisy Intermediate-Scale Quantum Computer. Für Berechnungen auf zukünftigen fehlerfreien Quantencomputern sowie heutigen NISQ-Computern ist die Verschränkung von Quantenzuständung eine unabdingbare Ressource. Gleichzeitig ist sie im Falle von NISQ-Computern auch eine große Herausforderung für ihre Genauigkeit, wie eine neue Forschungsarbeit jetzt zeigt.

NISQ-Geräte sind keine vollwertigen Quantencomputer: sie weisen eine beträchtliche Störanfälligkeit bzw. „Rauschen” auf und verfügen nur über eine geringe Anzahl von Quantenbits (kurz: Qubits). Sie sind daher aktuell nicht in der Lage bereits existierende Quantenalgorithmen sinnvoll auszuführen. Dennoch geht man davon aus, dass sie für bestimmte Aufgaben, wie z. B. das Ziehen von Stichproben aus bestimmten Wahrscheinlichkeitsverteilungen, Fähigkeiten besitzen, die über die von klassischen Computern hinausgehen. Ob sie klassische Computer bei praktischen Problemen wie beispielsweise in der Chemie, der künstlichen Intelligenz oder Finanzberechnungen übertreffen können, bleibt allerdings ungewiss, da der Rauschpegel ihre Leistungsfähigkeit immens einschränkt. NISQ-Computer werden heute vor allem auf ihre Tauglichkeit bei Optimierungsproblemen, Quantensimulationen und maschinellem Lernen hin untersucht. Besonders klassische Optimierungsprobleme sind für die Wissenschaft und die Industrie von großem Interesse, weil es „schwierige Probleme“ sind, die oft in realen Situationen auftreten, wie zum Beispiel das Berechnen der schnellsten Route für Fahrer, die Pakete ausliefern, oder andere praktische Probleme im Maschinenbau, in volkswirtschaftlichen Fragen oder der Computerwissenschaft. Diese Probleme benötigen oft so viel Rechenpower, dass sie nahezu unlösbar sind, schlichtweg weil es zu lange dauern, würde sie zu knacken. Die Hoffnung ist, dass NISQ-Geräte diese Berechnungen beschleunigen können, aber bislang haben gibt es keinen Nachweis dafür, dass sie klassischen Computern bei klassischen Optimierungsproblemen überlegen sind, und es ist nicht klar, ob dies für diese Art von nicht fehlerkorrigierten Quantencomputern in Zukunft der Fall sein wird.

Guillermo Gonzalez und Rahul Trivedi, ein Team von Theoretiker vom Max-Planck-Institut für Quantenoptik (MPQ) unter der Leitung von Ignacio Cirac, haben jüngst in einer Arbeit, die im Fachmagazin PRX Quantum veröffentlicht wurde, die Auswirkungen des Rauschens auf die Qualität der Berechnungen klassischer Optimierungsprobleme auf NISQ-Geräten untersucht. Die Ergebnisse deuten darauf hin, dass die Fehler in NISQ-Geräten die Berechnungen sogar noch starker verfälschen können, als bisher angenommen. Der Grund dafür liegt in der Verschränkung – eine für die Leistungsfähigkeit von Quantencomputern unverzichtbare Ressource. Die Verschränkung ist ein exklusiver Wesenszug der Quantenphysik, der in der klassischen Welt nicht existiert. Wenn zwei Teilchen (oder Qubits) miteinander verschränkt sind, besteht zwischen ihnen eine starke Korrelation und eine Änderung des Zustands des einen bestimmt instantan den Zustand des anderen. Ohne Verschränkung kann es keinen Vorteil von Quantencomputern bei Quantenberechnungen geben.

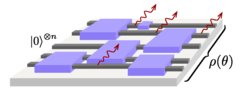

Dennoch ist Verschränkung ist ein zweischneidiges Schwert. Sie ist einerseits notwendig, um die Leistungsfähigkeit von Quantencomputern zu ermöglichen. Andererseits führt jeder Mechanismus zur Erzeugung von Verschränkung in einem Quantenschaltkreis auch dazu, dass sich Fehler in dem Schaltkreis ausbreiten. In ihrer Arbeit schlägt die Gruppe vom MPQ ein Modell auf der Grundlage von Zufallsgattern vor, das zeigt, dass sich ein Fehler in einem Qubit durch Verschränkung mit anderen Qubits schnell auf die anderen ausbreiten kann. Diese Ausbreitung von Fehlern geschieht möglicherweise in einem so großen Ausmaß, dass Quantenschaltungen ihren Vorteil gegenüber bekannten klassischen Algorithmen verlieren könnten. Um NISQ-Geräte also nutzbringend einzusetzen, ist es von zentraler Bedeutung, die Ausbreitung solcher Fehler zu begrenzen sowie ein besseres Verständnis davon zu erlangen, in welchen Situationen sich die Fehler ausbreiten, um letztlich bessere Quantenschaltkreise oder -algorithmen zu finden, in denen sich Fehler weniger stark ausbreiten oder die Ausbreitung von Fehlern weniger starke Folgen hat.